阿里巴巴在人工智能領域的探索再次邁出重要一步。其Qwen團隊繼3月推出Qwen2.5-Omni-7B模型后,4月30日又發布了該系列的輕量版本——Qwen2.5-Omni-3B模型。目前,這一新版本已在Hugging Face平臺上開放下載,供開發者和研究人員使用。

Qwen2.5-Omni-3B作為7B旗艦多模態模型的精簡版,專為消費級硬件設計,旨在提供覆蓋文本、音頻、圖像和視頻等多種輸入功能的強大性能。盡管參數規模有所縮減,但團隊表示,3B版本在多模態性能上仍保持了7B模型90%以上的水平,尤其在實時文本生成和自然語音輸出方面表現尤為突出。

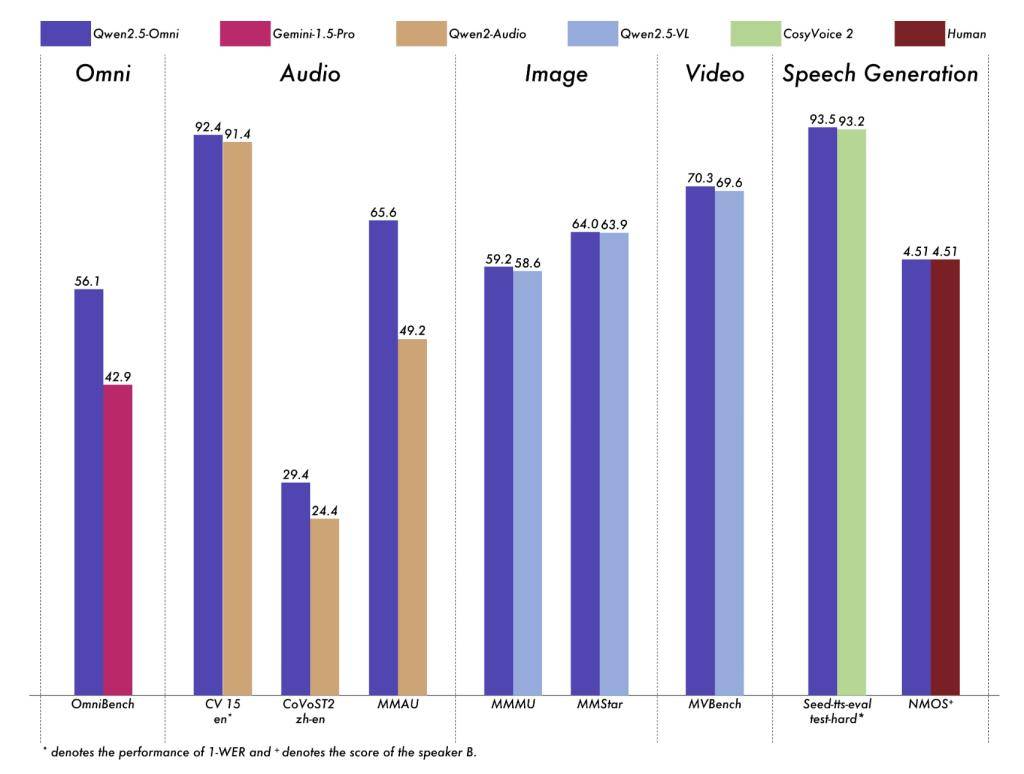

基準測試數據顯示,Qwen2.5-Omni-3B在視頻理解和語音生成等任務中的表現接近7B模型。例如,在VideoBench視頻理解測試中,3B版本取得了68.8的分數;在Seed-tts-eval語音生成測試中,其在hard難度下獲得了92.1的高分。

值得注意的是,Qwen2.5-Omni-3B在內存使用上的優化尤為顯著。在處理長達25,000 token的上下文輸入時,該模型的VRAM占用減少了53%,從7B模型的60.2 GB降至28.2 GB。這意味著Qwen2.5-Omni-3B可以在配備24GB GPU的高端臺式機和筆記本電腦上運行,無需依賴企業級GPU集群。

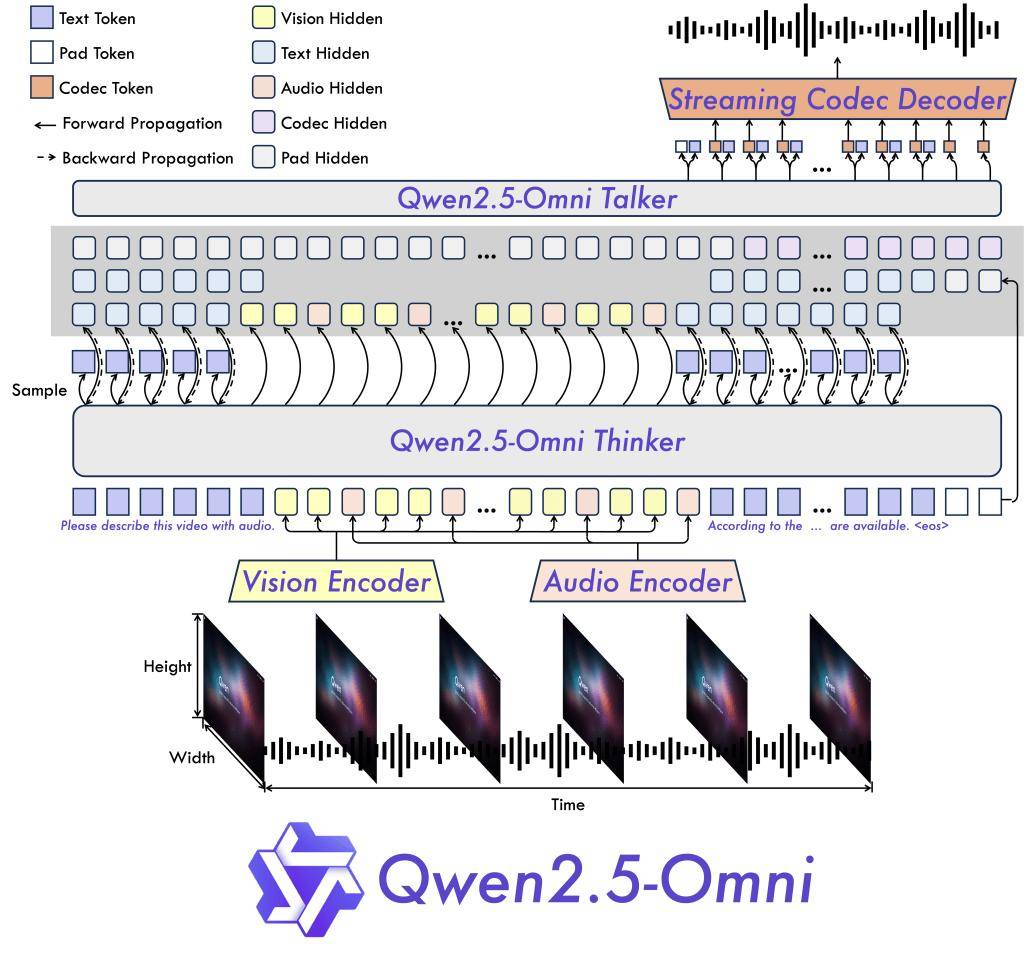

Qwen2.5-Omni-3B的架構創新也是其性能卓越的關鍵因素之一。該模型采用了Thinker-Talker設計和定制位置嵌入方法TMRoPE,確保了視頻與音頻輸入的同步理解。它還支持FlashAttention 2和BF16精度優化,進一步提升了處理速度并降低了內存消耗。

然而,Qwen2.5-Omni-3B的使用也受到一定的限制。根據許可條款,該模型目前僅限于研究用途。企業若希望將其用于商業產品開發,必須先從阿里巴巴Qwen團隊獲得單獨的許可。這意味著Qwen2.5-Omni-3B目前并不直接面向生產部署,而是更偏向于測試和原型開發階段。