近日,全球知名科技媒體marktechpost報道了一則重要消息,英偉達正式開源了其Open Code Reasoning(OCR)模型套裝。該套裝包含了三種不同規模的模型,分別是32B、14B和7B,均基于Apache 2.0許可證進行發布。用戶現在可以在Hugging Face平臺上輕松下載這些模型的權重和配置。

OCR模型套裝中的三種模型均采用了Nemotron架構,這是一種專為多語言和多任務學習優化的Transformer框架。32B模型定位在高性能推理和研究領域,為用戶提供卓越的效果;14B模型則在降低計算需求的同時,依然保持了強大的推理能力;而7B模型則更適合資源受限的環境,能夠在基準測試中展現出不俗的表現。

尤為32B模型還推出了指令微調版本,這一版本與開放推理生態系統無縫兼容,并支持適配llama.cpp、vLLM、Hugging Face Transformers和TGI等主流框架。這無疑為開發者提供了極大的便利,使他們能夠快速集成并應用這一先進的模型。

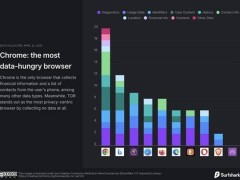

在代碼推理領域,OCR模型套裝展現出了驚人的實力。根據LiveCodeBench基準測試的結果,OCR模型全面超越了OpenAI的o3-Mini和o1(low)模型。這一成就不僅彰顯了模型架構的優化成果,也凸顯了英偉達在打造定制“OCR數據集”方面的深厚功底。該數據集專注于高質量代碼訓練,注重指令遵循、推理能力和多步驟問題解決能力的培養。

具體來看,在LiveCodeBench的各項測試中,OCR-Qwen系列模型表現尤為突出。7B版本的OCR-Qwen-7B-Instruct在Avg.CodeContest和All兩項指標上分別達到了51.3和18.1的高分;14B版本的OCR-Qwen-14B-Instruct則分別取得了59.4和23.6的優異成績;而32B版本的OCR-Qwen-32B-Instruct也毫不遜色,兩項指標分別為61.7和24.4。這些數據充分證明了OCR模型套裝在代碼推理領域的領先地位。

除了OCR-Qwen系列模型外,其他經過蒸餾的模型如Bespoke-Stratos、OpenThinker、R1-Distill-Qwen和OlympicCoder等也在測試中取得了不俗的成績。然而,與OCR模型相比,它們在Avg.CodeContest和All兩項指標上的表現仍有一定的差距。

LiveCodeBench是一個專注于調試、代碼生成和邏輯補全等真實開發者環境中任務的綜合評估平臺。通過在該平臺上的測試,OCR模型套裝充分展示了其在代碼推理領域的卓越性能和廣泛應用前景。這無疑為英偉達在人工智能領域的持續創新和領先地位注入了新的動力。